L’action d’une personne sur un objet réel ou abstrait peut toujours être jugée par les autres:soit la personne exprime une gentillesse ou une méchanceté.

Quand on donne de la nourriture à des animaux on est gentil. Quand on hurle sur un bébé on est méchant.

La réaction après une action est différente selon qu’on est gentille ou méchante .

Notre projet vise à illustrer cet aspect d’action et de réaction à travers le numérique.

Dès le début nous pensions faire un aquarium virtuel et interagir avec les poissons mais nous avons finalement décidé d’en faire un environnent plus simple et abstrait.

Cet aspect non concret laisse libre court à l’imagination.

Par exemple on pourrait s’imaginer nourrir des poussins, des souris ou encore des spermatozoïdes qui courent vers un ovule, etc ….

Réalisation

Pour la réalisation du projet nous avons utilise le logiciel Processing avec la technologie leap motion (l’utilisateur utilise sa main pour interagir avec les formes) et les websockets pour le dialogue entre les formes et les utilisateurs.

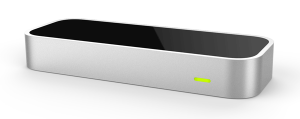

Le Leap Motion (ou Leap Motion Controller) est un dispositif de reconnaissance de mouvement des mains, pour la réalité virtuelle, créé par Leap Motion, Inc

Le Leap Motion (ou Leap Motion Controller) est un dispositif de reconnaissance de mouvement des mains, pour la réalité virtuelle, créé par Leap Motion, Inc

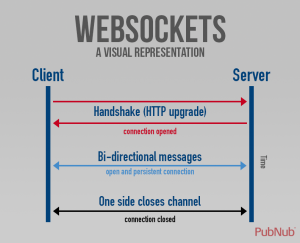

WebSocket est un standard du Web désignant un protocole réseau de la couche application et une interface de programmation du World Wide Web visant à créer des canaux de communication full-duplex par-dessus une connexion TCP.

Le principe majeur de Processing est la simplicité dans la mise en œuvre des programmes comme dans la syntaxe du langage. Adapté à la création graphique, Processing réclame moins d’efforts que Java pour effectuer des tâches simples telles que la modification d’une animation à intervalle régulière (qui permet des créations animées).

Processing est fait par et pour les artistes.

Le gameplay

Le jeux est constitué de formes qui cherchent à attirer l’attention des personnes pour les amener à interagir avec elles.

Leurs objectifs majeurs est d’empêcher aux gens de penser que c’est juste un arrière plan et les ignorer.

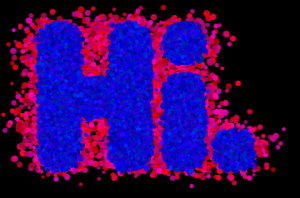

Pour cela, les formes étant sensibles au bruit vont se regrouper soit pour dessiner un émoticon qui fait un clin d’œil aux gens, soit écrire le texte <<HI>>.

Les utilisateurs peuvent aussi répondre par des mots simples comme <<Hi>>, <<Hello>> .

Puis les formes vont leur dire « how are you » et ils vont repondre « fine » ou « I’am fine ».

Ensuite ils vont exprimer leur faim.et là les utilisateurs peuvent avec leurs mains,leur donner à manger.

En retour les formes vont avoir des couleurs plus joyeuses et vont dessiner des jolies figures pour les remercier.

Si on les crie dessus, elles vont se fâcher et dans ce cas elles vont avoir des couleurs horribles et dessiner des figures en conséquence.

Par contre si personne n’interagit avec elles, elles vont mourir.

Lien de téléchargement du code source: https://github.com/bambandiaye181/myfishe2

Perspectives:

Nous envisageons d’implémenter plus d’interactions,rendre les formes plus autonomes et changer leur aspect au fil du temps,mettre des sons etc.

Références :

Pour l’utilisation de leap motion ,nous avons utilisé la librairie Leap motion for processing disponible dans processing.

Pour les websockets ,nous avons utilisé la librairie websockets et comme serveur https://codepen.io/getflourish/pen/NpBGqe

Vous pouvez suivre ce lien pour voir le tutoriel sur l’utilisation du speech recognition http://florianschulz.info/stt/